Niedawna sprawa błędów i fałszywych przypisów w książce Karoliny Opolskiej, do których powstania przyczyniło się użycie sztucznej inteligencji, jest jedynie wierzchołkiem góry lodowej. Coraz liczniejsze przykłady z polskiego i światowego rynku pokazują, że bezkrytyczne poleganie na sztucznej inteligencji w działalności zawodowej – dziennikarstwie, prawie czy biznesie – prowadzi do niekontrolowanego rozprzestrzeniania się dezinformacji, poważnych błędów merytorycznych i rzeczywistych strat finansowych.

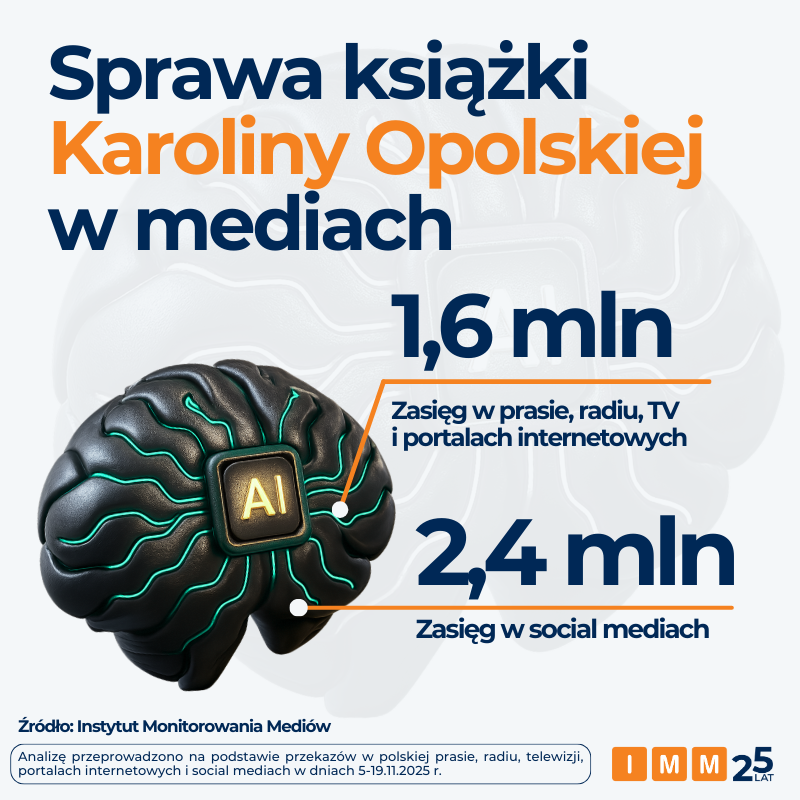

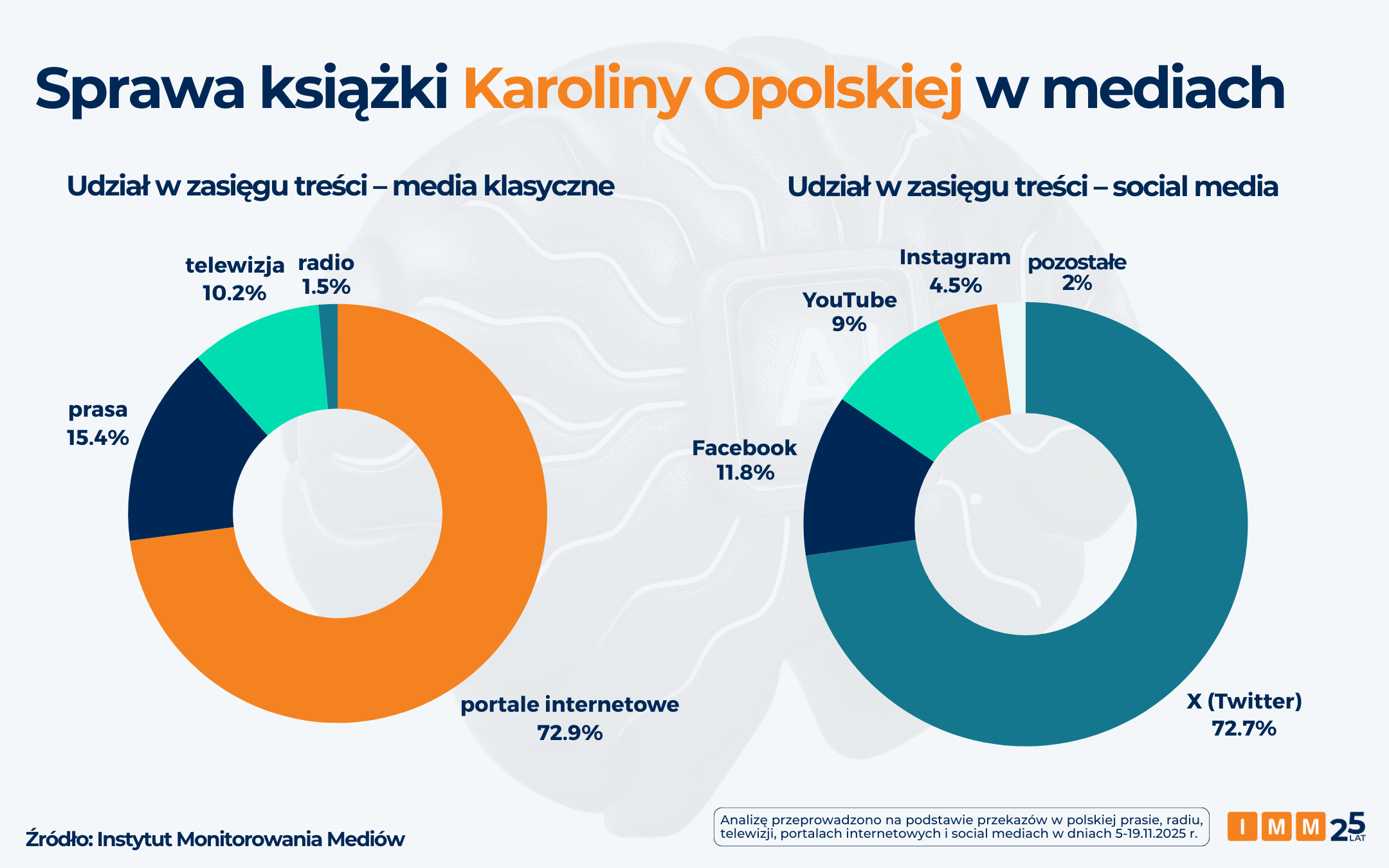

Przypadek polskiej dziennikarki Karoliny Opolskiej, w którym model AI prawdopodobnie (pomimo braku formalnego przyznania się do tego faktu przez wydawcę i autorkę, wątpliwości pozostają silne i są szeroko komentowane) wygenerował nieistniejące źródła i błędne informacje, doskonale ilustruje zjawisko tzw. halucynacji AI. Analitycy Instytutu Monitorowania Mediów, sprawdzili, że sprawa ta osiągnęła 4 mln potencjalnych kontaktów z przekazem (1,6 mln w mediach klasycznych i 2,4 mln w mediach społecznościowych) w okresie 5-19 listopada 2025 roku. Oznacza to, że statystycznie z mediów dowiedziała się o niej co ósma osoba w Polsce w wieku od 15 r.ż.

Na tym przykładzie widać, że problem halucynacji AI nadal jest stosunkowo słabo widoczny w przestrzeni publicznej. Z tego powodu warto stale edukować internautów na temat sposobów rozpoznawania treści generatywnych oraz informować ich o zagrożeniach, jakie za sobą niosą. Szczególnie publikacje opisujące bieżące sprawy z obszarów polityki, bezpieczeństwa czy biznesu, ze względu na szybkie tempo ich powstawania, są narażone na manipulację, nasycenie nieprawdziwymi danymi i w konsekwencji szeroką dezinformację mediów oraz opinii publicznej.

„Sprawa Karoliny Opolskiej szybko przekształciła się w mediach społecznościowych w ostrą dyskusję o moralności i wiarygodności osób publicznych. Z analizy ekspertów IMM wynika, że dominujący ton we wpisach jest zdecydowanie negatywny. Użytkownicy sieci oskarżają Opolską o nadużycie zaufania jako dziennikarki. Równolegle trwa dyskusja o wzroście nieufności społecznej do nowych technologii” – mówi Tomasz Lubieniecki, kierownik działu raportów medialnych IMM.

Polska codzienność halucynacji AI

Problem halucynacji AI przestał być medialną ciekawostką, a stał się realnym problemem w polskim biznesie i mediach. Jedną z podobnych spraw ostatnich miesięcy (1,3 mln zasięgu wg danych IMM z okresu od 26 października do 10 listopada 2025 r.) był przypadek firmy Exdrog, wykluczonej z przetargu na utrzymanie dróg, w której halucynacje AI miały bezpośrednie skutki prawne i finansowe. Firma, broniąc rażąco niskiej ceny, przedstawiła Krajowej Izbie Odwoławczej dokumentację opartą na AI – jak się okazało, zawierającą całkowicie zmyślone, nieistniejące interpretacje podatkowe i przepisy prawne, mające uzasadniać zawarte w ofercie wyliczenia.

AI jako źródło globalnych wpadek

Przypadki Opolskiej czy Exdrog to nie odosobnione incydenty, ale polski odpowiednik globalnego trendu. Na całym świecie halucynacje AI doprowadziły już do kompromitacji prawników (powołujących się w sądzie na zmyślone precedensy) czy wpadek medialnych, jak w przypadku „Chicago Sun-Times”, gdzie AI wygenerowało artykuł polecający czytelnikom… nieistniejące książki.

Problem potwierdzają globalne statystyki: badanie przeprowadzone przez BBC na zlecenie Europejskiej Unii Nadawców (EBU) pokazało, że ChatGPT, Microsoft Copilot, Google Gemini i Perplexity niemal w połowie przypadków zniekształcały informacje. Analiza ponad 3000 odpowiedzi wygenerowanych przez te narzędzia ujawniła, że 45 proc. z nich zawierało przynajmniej jeden istotny błąd.

Problem odpowiedzialności i erozja standardów

Rosnąca fala błędów generowanych przez AI rodzi fundamentalne pytanie o odpowiedzialność prawną. Jak zauważa prof. Justyna Król-Całkowska, ekspertka ds. prawa i AI, obecnie nie mamy jasności prawnej, kto odpowiada za szkody wyrządzone przez halucynacje AI: twórca algorytmu, dostawca usługi, czy użytkownik, który bezkrytycznie skopiował tekst.

„Obecne modele AI to potężne narzędzia statystyczne, lecz nie posiadające świadomości ani zrozumienia prawdy. Traktowanie ich jak bezbłędnej wyroczni i pomijanie etapu ludzkiej, krytycznej weryfikacji to nie tylko błąd w sztuce, ale prosta recepta na katastrofę wizerunkową i finansową” – mówi Tomasz Lubieniecki z IMM.

Jak rozpoznawać treści generowane czysto przez AI?

Aby skutecznie chronić się przed dezinformacją i halucynacjami AI, szczególnie ważne jest odpowiedzialne i krytyczne podejście do wszelkich badań oraz analiz, które mogą wyglądać profesjonalnie, ale w rzeczywistości zostały w całości wygenerowane przez modele językowe. Istotna jest umiejętność oceny wiarygodności źródeł i sprawdzania, czy prezentowane dane mają faktyczne oparcie w rzeczywistości. Eksperci IMM, w oparciu o własne doświadczenia, opracowali zestaw charakterystycznych cech, które mogą wskazywać na to, że treść została stworzona wyłącznie przez sztuczną inteligencję i wymaga skrupulatnej weryfikacji danych źródłowych:

1. Styl i prezentacja

- Schematyczność i „idealne” formatowanie: zwróć uwagę na charakterystyczne, specjalne formatowanie, które często wygląda zbyt idealnie, nienaturalnie schematycznie lub jest nadmiernie ujednolicone.

- Sensacyjność i clickbait: początek analizy ma często sensacyjny ton i dąży do generowania clickbaitu (zbyt chwytliwe, wzbudzające silne emocje nagłówki).

2. Dane i źródła

- Niewiarygodne procenty: alarmujące powinny być wyjątkowo wysokie, jednostronne procenty (np. 93 proc.), podawane bez wiarygodnego kontekstu metodycznego, często mające na celu manipulację emocjami i udawanie rzetelnych badań.

- Brak metodologii: zwykle brakuje jasnej i transparentnej metodologii prezentowanych analiz lub jest ona celowo zawiła i trudna do zweryfikowania.

- Brak ram czasowych danych: częstym błędem jest brak podawania konkretnego okresu, z jakiego pochodzą analizowane dane.

- Tempo powstawania: bardzo szybkie tempo powstawania tzw. „analiz” – gdy od momentu wygenerowania danych do podania wniosków mija zaledwie godzina lub dwie.

3. Język i słownictwo

- Katalog ulubionych słów LLM-ów: zwróć uwagę na nadmierne lub automatyczne użycie słów-kluczy i fraz, które są charakterystyczne dla dużych modeli językowych (LLM), np. nadużywanie przymiotnika „kluczowe”. W procesie identyfikacji pomocne są narzędzia, które weryfikują teksty podejrzane o tworzenie ich z dużym wykorzystaniem AI.

Przed dalszym kolportowaniem treści lub wniosków zawsze warto sprawdzić, jak duży udział miała sztuczna inteligencja w procesie twórczym, a następnie zweryfikować źródło lub porównać wynik z danymi, na podstawie których powstała analizowana treść. Szczególnie duże ryzyko wystąpienia halucynacji AI oraz błędnych danych liczbowych i procentowych niosą treści generowane w 90-100 proc. przez modele sztucznej inteligencji.

Autorka: Anna Sanowska, członkini Rady Nadzorczej Instytutu Monitorowania Mediów.

Metodologia

Analizę na temat wykorzystania AI w książce Karoliny Opolskiej przeprowadzono na podstawie przekazów w polskiej prasie, radiu, telewizji, portalach internetowych i social mediach w dniach 5-19 listopada 2025 roku.

Analizę na temat wykorzystania AI przez firmę Exdrog przeprowadzono na podstawie przekazów w polskiej prasie, radiu, telewizji, portalach internetowych i social mediach w dniach 26 października – 10 listopada 2025 roku.